更新日:2026/02/21 投稿日:2026/02/10

ここ数年ARMノートを追っていて、ここ最近は国内メーカーからもARMノートが出てきたので、ちょっと見てきた話。

ARMと言えば近年のMacbookに代表されるように、低発熱でバッテリー持ちがいいというのが話題だが、つい最近までは海外製で1kg越えだったり、JISキーボードがないものが主体だったが、遂に東芝や富士通も出すようになり、JISキーボードを備えた軽量ノートも出てきていい流れなので、実際にどんなものか、軽く見てくることにした。

ヨドバシの展示機を使って発熱とバッテリー持ちを比較してきたので、その内容をまとめる。

富士通のノートPCで、Snapdragon XとCore Ultra 7のものを見てきた。

比較するにはバッテリー容量が異なる。これはヨドバシの店頭展示品で試してきた都合、同じものがなかったためだ。但しバッテリー持ちはバッテリー容量に比例するため、本記事では単純に倍換算にして計算する。

FMVUQSL1BC FMVUXSK3BC

CPU

Snapdragon X X1-26-100

Intel Core Ultra 7 255U

画面

14.0型ワイド FHD

14.0型ワイド FHD

バッテリー

63Wh

31Wh

消費電力:標準時/最大時/スリープ時

約5.6W / 約65W / 約1.0W

約5.3W / 約65W / 約1.1W

重量

876g

634g

数値上はCore Ultraが有利そうだが…実際のところはどうか比較してきたので下に続く。

Intel、Core Ultra シリーズ2正式発表。Armより低消費電力で高性能 なんて記事もあるので、Core Ultraに期待していたが、勝負にすらならなかった。

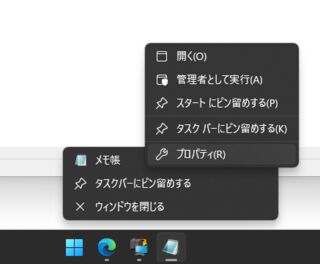

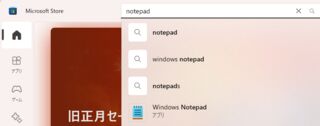

電源オプションを「最適なパフォーマンス」にした状態で、CPU負荷ツール.js でカウンタが6Gに到達するまでぶん回した結果。

CPU負荷ツール.jsのカウンタが6Gになるまで回したところ、ARMマシンであるFMVUQSL1BC は、ファンがかなりの音を立てて回っていたが、ほのかに暖かくなる程度で、膝の上で使っていてもパフォーマンスの不安はなさそうに感じた。

対するCore UltraのFMVUXSK3BC は、ファンは静かなものの、600M辺りで明らかに熱くなり、カウンタの周りの劣化が明らかで、2Gになる前に止めてしまった。恐らく負荷をかけるのには全く向かないだろう。

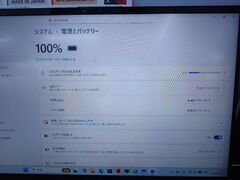

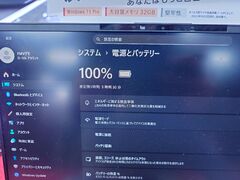

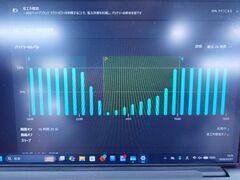

こちらは電源オプションを「最適なパフォーマンス」にした状態で、アイドル状態のバッテリー持ちを比較している。

ARMマシンであるFMVUQSL1BC は推定残り時間が1日1時間31分と驚くべき時間が出て、すぐに13時間24分となった。「最適なパフォーマンス」で13時間は驚異的な数値だ。

バッテリーの低下速度も見てみたが、恐らく閉店後にブレーカーが落とされてからは緩やかに減っているのがわかる。このグラフは電源オプションが「バランス」の状態で出ていると思われる。設定変更前は「バランス」だったからだ。

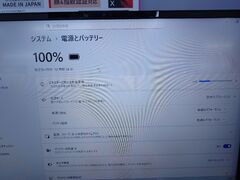

対するCore UltraのFMVUXSK3BC は、3時間30分と出ており、なんとも頼りない。本機はバッテリーが前述のARM機の半分しかないが、仮に同一容量であったとしても、7時間しか持たないだろう。これは基本的にバッテリー持ちはバッテリー容量に比例するからだ。

バッテリーの低下速度もすさまじく、閉店時間中に尽きてそうな勢いだ。このグラフも電源オプションが「バランス」の状態で出ていると思われる。こちらの個体も設定変更前は「バランス」だったからだ。

ARM PCと言えば、2020年あたりにAppleがいわゆるM1 Macを出してからARM化の波が来ていて、MicrosoftもWindows 10を乗せたSurface Pro XからはARM対応を進めているが、初期はMicrosoftくらいしかなく、後にLenovoやDell、HPが出てきて、そのうちASUSも出てきたが、長らく国産機は出てこず不満だった。

しかし去年Dynabook初のSnapdragon搭載ノートPCをリリースした のを皮切りに、年初に富士通の最軽量ノートシリーズからもARM対応版がリリースされた 。

ARMと言えばRISCアーキテクチャなので、かつてPowerPCを採用していたMacからすると先祖返り感があるが、Windowsは長らくCISCで、例えばIntelのx86が長らく主流で、今もAMD64が主流であることから、長くCISCが続いている。

そしてこの流れは当面変わらないだろう。何故ならWindowsはMacのように端末を丸ごと出すのではなく、各ベンダーの設計や自作PCも可能な設計にしているからだ。まさかこれを取り崩すことはしないだろう。

コンポーネントが分かれていて色々組み合わせられるのは様々な用途のマシンを作るうえで都合がいいし、ここを標準化してしまうとつまらないし、Appleみたいに寡占された市場ができてしまい不健全でもある。

しかし、ことモバイル端末に限って言えば別だ。ゲーミングノートのように常時電源に繋いで高パフォーマンスが求められる環境ならともかく、事務作業レベルさえできればいいようなレベルではバッテリー駆動でどれだけ長く作業できるかが重要だ。

例えば出先でデジカメの写真を加工したり、記事を書いたりするのには左程高スペックはいらない。そうなってくると元々特に高くなかったハードウェアの多様性はあまり必要ではなく、ARMでも十分になってくるだろう。

取り敢えず私としては大半のノートPCのカーソルキーとサイズに不満があるのでLavieの13.3型ノートにARM版が来てほしいところなので、NECに期待したい。