投稿日:

なんか昔のやり方が使えなくなってたので調べたメモ。

確認環境

| Env | Ver |

|---|---|

| OS | Ubuntu 24.04.3 LTS |

| Docker | version 28.1.1, build 4eba377 |

| Docker Compose | v2.35.1 |

| Mastodonのバージョン | v4.5.0-alpha.2 |

| Mastodonのコミットハッシュ | 06803422da3794538cd9cd5c7ccd61a0694ef921 |

手順

DEVELOPMENT.md#dockerの手順通りにやると行ける。

docker compose -f .devcontainer/compose.yaml up -d

docker compose -f .devcontainer/compose.yaml exec app bin/setup

docker compose -f .devcontainer/compose.yaml exec app bin/dev

コンテナへのアタッチ方法

# 方法1

docker compose -f .devcontainer/compose.yaml exec app zsh

# 方法2

cd .devcontainer

docker compose exec app zsh

VSCodeがあるならDockerやRemoteほげほげ系の拡張を使い、devcontainer-appにAttach Shellしてもよい。

検証ユーザーの作成

- 次のコマンドでユーザーを作る

./bin/tootctl accounts create hoge --email hoge@example.com --confirmed - ユーザーの承認を行い、必要に応じてパスワードを使いやすいものに変更する

rails console user = Account.find_by(username: 'hoge').user user.approve! # PW変更ここから user.password = 'password' user.skip_confirmation! # PW変更ここまで user.save! quit

フロントエンドのビルドとサーバー起動

bin/rails assets:precompile

bin/dev

トラブルシューティング

localhostではアクセスできるが、マシンのホスト名やhoge.testのようなローカルドメインでアクセスできない

.env.developmentにALTERNATE_DOMAINS=hoge.testの行を追加することで他のドメインでもアクセスできる。

この設定があるとMastodonを別環境で動かしててリモートからドメインアクセスする場合に便利。

ActiveRecord::PendingMigrationErrorなど、ActiveRecord関係のエラーが出る

コンテナの中でrails db:setupを叩くことで解決する。

Unable to load application: NameError: uninitialized constant LetterOpenerWebというエラーが出る

リポジトリルートにあるdocker-compose.ymlを使うと発生するので、.devcontainer/compose.yamlを使う事で解決する。

あとがき

検証用にバニラなMastodon環境が欲しくて作ってみたが昔と変わっていて地味にハマった…。

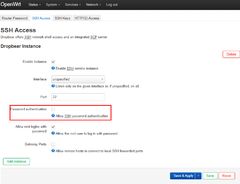

adiaryの痒い所をちょこちょこ直している。上の画像にはないがCtrl + Vでクリップボードの画像をアップロードできる機能も付けている。

変更差分はもっぱらGitHubで管理していて、今日も最新版に追従させたところだ。

最近はOGPを強制出力するようにしたり、今日はSyntax HighlightをPrism.jsに置き換えるなどしていた。

adiaryはDiscordのようにChromeに詐称してくるBOT相手だとOGPが出ないし、標準のSyntax Highlightはしょっぱい。

比較用に元のやつを撮っておくのを忘れてしまったが、正直かなり良くなったと思う。

スマホで見たときに行折れせずスクロールできるようになったのも良い。

投稿日:

Mastodonの最大アップロードサイズを変更する

確認環境

| Env | Ver |

|---|---|

| Mastodon | v4.5.0-alpha.2 |

| nginx | 1.26.1 |

手順

- Mastodonのapp/models/media_attachment.rbの

IMAGE_LIMIT,VIDEO_LIMIT,MAX_VIDEO_MATRIX_LIMIT,MAX_VIDEO_FRAME_RATE,MAX_VIDEO_FRAMES辺りをいい感じに直す - nginxのmastodon用設定を開き、

client_max_body_size 100m;をいい感じに直す - mastodonとnginxを再起動する

- 適当にデカいファイルをあげて確認する

- 確認用ファイルを消したい場合は、

public/system/media_attachments/files/にあるので消す

Mastodonの最大投稿文字数を増やす

確認環境

Mastodon v4.5.0-alpha.2

手順

投稿可能な文字数を増やすを参照。

注目タブを固定した投稿に変更する

確認環境

Mastodon v4.5.0-alpha.2

やり方

割と力押してやったのでイケていない。

- 変更時の差分を参考に改造

資材のビルドを行い、Webを再起動

RAILS_ENV=production bundle exec rails assets:clobber RAILS_ENV=production bundle exec rails assets:precompile

必要に応じてsudo chown -R mastodon /home/mastodonで所有権を戻しておく。

TL周りのCSSをいじる

確認環境

Mastodon v4.5.0-alpha.2

手順

app/javascript/styles/mastodon/components.scssを適当に編集資材のビルドを行い、Webを再起動

RAILS_ENV=production bundle exec rails assets:clobber RAILS_ENV=production bundle exec rails assets:precompile

必要に応じてsudo chown -R mastodon /home/mastodonで所有権を戻しておく。

文字が詰まって気持ち悪いのを直す

確認環境

Mastodon v4.5.0-alpha.2

内容

手順

app/javascript/styles/mastodon/basics.scssに以下の行を足す。html { &:lang(ja) { text-spacing-trim: space-all; } }資材のビルドを行い、Webを再起動

RAILS_ENV=production bundle exec rails assets:clobber RAILS_ENV=production bundle exec rails assets:precompile

ピン止めの上限を増やす

デフォルトは5つまでしかできないので…。

確認環境

Mastodon v4.5.0-alpha.2

手順

app/validators/status_pin_validator.rbを開くPIN_LIMITを増やすsudo service mastodon-web restartで再起動

AUTOMATIC1111の更新は長らく止まっており、新しいツールを探していてComfyUIを試したりしていたのだが、Hire fixに相当する機能に当たることが出来ず、どうにもイマイチだった。

そこでかつてAUTOMATIC1111からフォークされ、AUTOMATIC1111にマージされたForgeからreForgeが新たに派生していることを知ったので試してみたが、これがかなり良かった。生成速度は爆速になったし、複数キャラの絡みも自然にできるようになった。

reForgeは既に開発が停止しているようだが、逆に言えば安定していると言う事でもある。

というわけで試した結果をつづっていく。

導入

git pullしたらwebui.bat叩いて終わりなので特筆することはない。AUTOMATIC1111とディレクトリ構造が同じなので、extentionやmodel, loraなどの環境はそのまま引っ越せる。

爆速化したベンチマーク

前回のベンチマークでは平均生成速度2.911it/s、生成時間120秒だったが、今回は平均生成速度4.352it/s、生成速度81秒まで短縮された。

これは前回最速を記録したUltra 7 265F + 4070Tiを12秒も凌ぐ速度で、極めて速い。正直コスパでNovelAIと勝負できるレベルだ。

ベンチマーク構成

ソフトウェア

reForegeにxformersは不要とのことで、xformersを入れていない。

| Env | Ver |

|---|---|

| version | f1.0.0v2-v1.10.1RC-latest-2446-ge1dcf9b4 |

| python | 3.11.9 |

| torch | 2.7.1+cu128 |

| xformers | N/A |

| gradio | 3.41.2 |

ハードウェア

前回とマザボが変わっているが、これによる差はないだろう。

| デバイス | 製品 |

|---|---|

| CPU | Intel Core Ultra 7 265F |

| GPU | GeForce RTX 5070 Ti |

| MEM | Crucial CT2K16G56C46U5 * 4 |

| M/B | ASRock Z890 Pro RS |

りこベンチ

ベンチマーク用の設定

コマンドライン引数なしでwebui.batを実行

| 設定 | 値 |

|---|---|

| Model | ntrMIXIllustriousXL_xiii.safetensors [1207404b17] |

| Clip skip | 2 |

| ENSD | 31337 |

| Propmpt | (illustration:1.0), masterpiece, best quality, 1girl, solo, happy, smile, theater, (perspective:1.3), from below, (looking away:1.2), (from side:1.0), {{shot_hair}}, smile, bangs, shaggy, (brown hair:1.1), swept_bangs, thick_eyebrows, skin_fang, closed mouth, {{purple eyes}}, gray {{jacket}}, white shirt, glasses, {{small breasts}}, |

| Negative Prompt | nsfw, (worst quality, low quality:1.4), (depth of field, blurry, bokeh:1.5), (greyscale, monochrome:1.0), multiple views, text, title, logo, signature, (tooth, lip, nose, 3d, realistic:1.0), dutch angle,(cropped:1.4), text, title, signature, logo, (loli:1.2), school satchel, pink, school bag, school uniform, from behind |

| VAE | Automatic |

| Sampleing method | DPM++ 2M |

| Hires. fix | True |

| Upscaler | Latent |

| Hires steps | 0 |

| Denoising strength | 0.8 |

| Upscale by | 2 |

| Sampleing steps | 20 |

| Width | 768px |

| Height | 768px |

| Batch count | 5 |

| Batch size | 1 |

| CFG Scale | 7 |

| Seed | -1 |

生成ログ

20/20 [00:02<00:00, 6.90it/s]

20/20 [00:11<00:00, 1.70it/s]

20/20 [00:02<00:00, 6.96it/s]

20/20 [00:11<00:00, 1.71it/s]

20/20 [00:02<00:00, 7.06it/s]

20/20 [00:11<00:00, 1.70it/s]

20/20 [00:02<00:00, 7.14it/s]

20/20 [00:11<00:00, 1.70it/s]

20/20 [00:02<00:00, 6.98it/s]

20/20 [00:11<00:00, 1.67it/s]

200/200 [01:21<00:00, 2.46it/s]

200/200 [01:21<00:00, 1.66it/s]

前回のベンチマークでは平均生成速度2.911it/s、生成時間120秒だったが、今回は平均生成速度4.352it/s、生成速度81秒まで短縮された。

平均生成速度

4.352it/s (前回比 +1.441it/s)

生成時間

81秒 (前回比 -39秒)

まとめ

明らかに爆速になった。これだけ早ければ何の文句もない。総合点でNovelAIと勝負できるレベルといっても過言ではないだろう。

複数キャラを配置できるForge Coupleの力

Forge CoupleというExtentionsが出ており、これを使うと複数キャラをNovelAI並みの自然さで配置できる。安定性ではNovelAIには敵わないのだが、無料で勝負できるところに価値がある。これがあればもうRegional Prompterは窓から投げ捨てていい。

Forge Coupleを使えばこのレベルは朝飯前だ。因みにこれはサンプルプロンプトそのままに近いが、キャラ同士の絡みも実現できる。

キャラ同士の絡ませ方の例(NSFW)

例えば、以下の条件であれば、ふたなりアスナと直葉の断面図あり挿入シーンという難題さえこなして見せる。かなりドギツイのが出てくるので試したい人はプロンプトをよく確認してほしい。かなり地獄のようなワードが入りすぎている。

nsfw, hentai illust, {num: 2girls}, 1dickgirls and 1girls, wet hair, drool,wet and messy, {cup: asuna to suguha}, very aesthetic, masterpiece, no text, from side, female sex, female sex from behind, female only

{num}, {cup}, couple, girl, kirigaya suguha, sao, large breast, large areola, white skin, (bob cut), armpit hair, pubic hair, doggy style, x-ray, creampie, ahegao, full body

{num}, {cup}, couple, dick girl, asuna (sao), A adult tall beauty crossdresser,shemale, little breasts, sagging breats, (dark nipple), little long nipples,wetty hair, hentai anime , long gloves and high socks, enjoying,smile,heart eyes, erection foreskin dick,smegma, armpit hair, pubic hair, hairy, tatoo,normal dick, sex, cum in cevio, ahegao, full body,

Negative prompt: lowres, artistic error, film grain, scan artifacts, worst quality, bad quality, jpeg artifacts, very displeasing, chromatic aberration, dithering, halftone, screentone, multiple views, logo, too many watermarks, negative space, blank page, low quality, child, text, speaking, censored. male, boy, male sex, 1boy

Steps: 20, Sampler: DPM++ 2M, Schedule type: Karras, CFG scale: 6, Seed: 1605499267, Size: 768x512, Model hash: c3688ee04c, Model: waiNSFWIllustrious_v110, Denoising strength: 0.85, Clip skip: 2, Hires CFG Scale: 6, Hires upscale: 2, Hires upscaler: Latent, forge_couple: True, forge_couple_compatibility: False, forge_couple_mode: Advanced, forge_couple_separator: \n, forge_couple_mapping: "[[0, 1, 0, 1, 1], [0, 0.5, 0, 1, 1], [0.5, 1, 0, 1, 1]]", forge_couple_common_parser: { }, Pad conds: True, Version: f1.0.0v2-v1.10.1RC-latest-2446-ge1dcf9b4

ポイントは一行目のfrom side, female sex, female sex from behind, female onlyと、2~3行目のキャラクター設定行にある{num}, {cup}, couple,だ。

まずfrom sideのように構図を指定していないと破綻しやすい。NovelAIのようにいい感じにはしてくれない。

次にふたなり百合をする場合、female sex, female sex from behind, female only辺りがあると良い。男が出てくる確率が目に見えて減る。

キャラクター設定についても{num}, {cup}で一行目の変数を参照し、プレイスタイルや人物属性の設定を強めることで出現率が大幅に向上する。またcoupleを付けることで、二人が出てくる確率が上がる。これがないと一人しか出てこなかったり、男が出てくる確率が増える。

トラブルシューティング

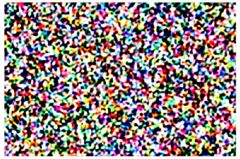

ノイズ画像が生成される

この様なノイズ画像が生成される時に「Number of Couples and Masks mismatched」というエラーが出ている場合、余計な空行が入っているのが原因なので、それを消すと直る。

Empty lines are still counted; ensure you do not leave an empty line at the end;